Deepfakes, die gefälschten Bilder, die von generativen KI-Modellen erzeugt werden, sind zunehmend überzeugender. Es wurde uns suggeriert, dass der Papst einen sehr modernen Anorak trug oder Donald Trump gewaltsam verhaftet wurde. Wir müssen daher immer wachsamer gegenüber den Bildern sein, die wir in sozialen Netzwerken sehen, und zwar nicht nur gegenüber den gefälschten, sondern auch gegenüber den echten.

Auf der Jagd nach Desinformation ist Elliot Higgins, ein Analyst bei OSINT (Open Source Intelligence), führend. Er begann vor einigen Jahren, seine Entdeckungen auf einer Website namens Bellingcat zu veröffentlichen, und seitdem hat sich seine Agentur zu einem Maßstab in diesem Bereich entwickelt. Er untersucht eine Vielzahl von Ereignissen und ist sich bewusst, dass die aktuelle Herausforderung im Bereich der Desinformation von künstlicher Intelligenz ausgeht.

Beide Seiten sind irreführend. Wie er kürzlich in einem Interview mit Wired erklärte: “Wenn Menschen an KI denken, glauben sie, sie wird Menschen dazu bringen, Unwahrheiten zu akzeptieren.” Aber in Wirklichkeit ermöglicht sie es den Menschen, Wahrheiten abzulehnen. Es ist das genaue Gegenteil.

Wir zweifeln sogar an dem, was wahr ist. Angesichts der Fülle an Fehlinformationen können Deepfakes und KI uns dazu verleiten, unseren Augen nicht zu trauen und zu denken: “Ach, das ist nur ein weiteres von KI erzeugtes Bild”, selbst wenn es sich um eine echte Aufnahme und Situation handelt.

Echt oder künstlich? Dies wurde kürzlich demonstriert, als er ein einzigartiges Foto erneut veröffentlichte. Eine Website, die KI-generierte Bilder identifizieren soll, behauptete, das Foto des von einer Menschenmenge umringten Journalisten sei wahrscheinlich von einer KI erstellt worden. Das Problem dabei ist, dass das Foto echt war (es gibt weitere Aufnahmen von dem Ereignis), was bedeutet, dass der Erkennungsdienst versagt hat.

Die Gefahr besteht darin, dass Maschinen Fotos identifizieren können. Diese Fotoerkennungssysteme prägen uns, da wir dazu neigen, ihren Schlussfolgerungen zu vertrauen. Dies erlebt eine Fotografin, die ihre Bilder an Instagram sendet und feststellt, dass ihre herkömmlichen Fotos vom Dienst als KI-generiert eingestuft werden.

Doch auch wir sind nicht fehlerfrei. Es scheint, als würden automatische Erkennungssysteme in solchen Fällen nicht zuverlässig funktionieren, und selbst unsere Augen können uns täuschen: Plattformen wie Midjourney haben demonstriert, dass der Fotorealismus, den generative KI-Modelle erreichen, beeindruckend ist und es zunehmend schwerer wird, Realität von Fiktion zu unterscheiden.

Tatsächlich sind Bilder nur ein Aspekt des Problems: Die Erstellung von Deepfakes, in denen Menschen kohärente Aussagen treffen und ihre Lippen synchron zu ihren Worten bewegen, sodass sie authentisch wirken, wird immer weiter perfektioniert. Wenn ein Video falsch, aber plausibel ist, könnten wir es für wahr halten. Das bedeutet, dass wir möglicherweise auch echte Videos anzweifeln.

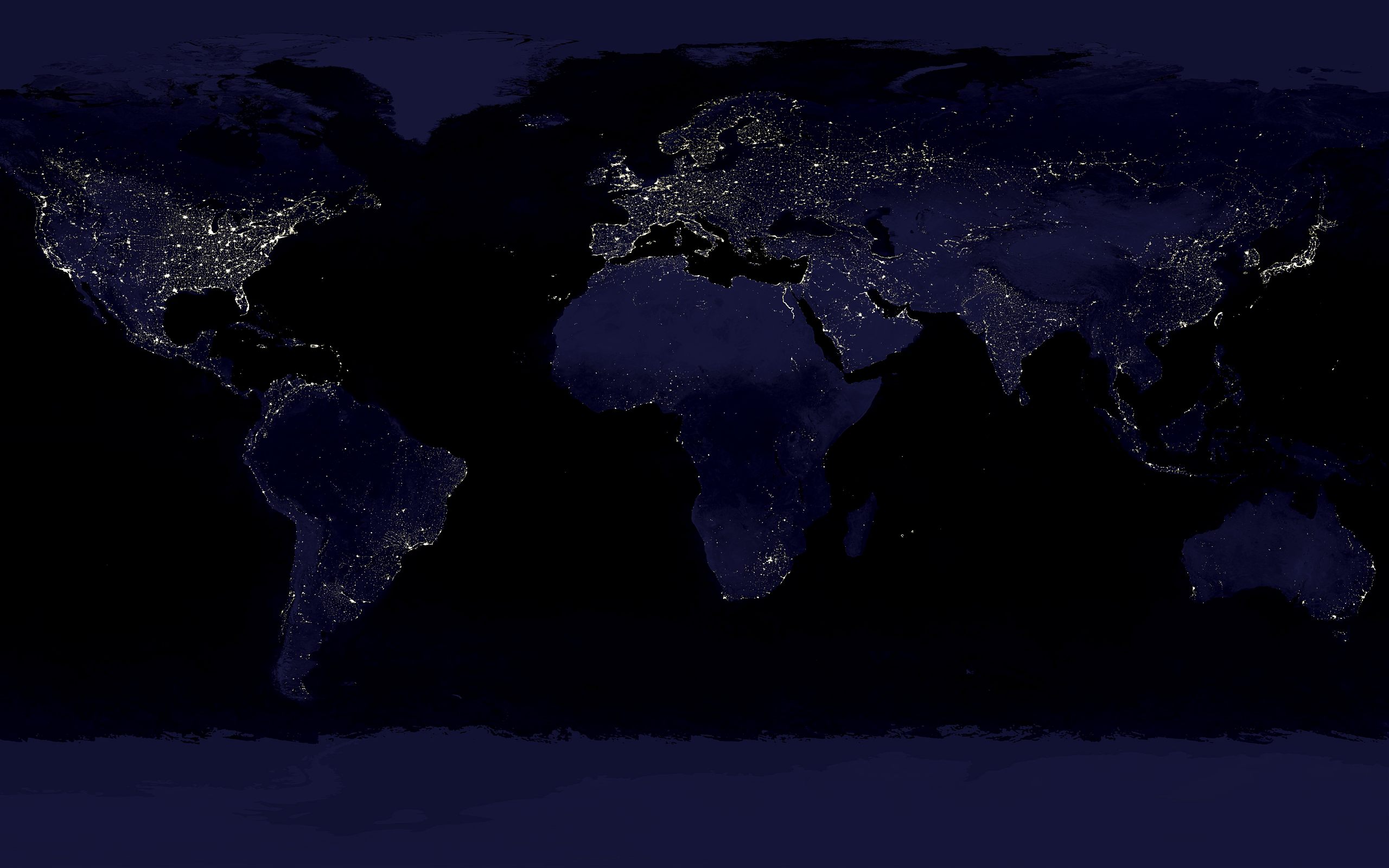

Bild | Almal3003.01 mit Midjourney

Werden Sie Teil unserer Community und unterstützen Sie uns! Sie können uns in den Sozialen Netzwerken am besten auf Telegram oder auf X oder Facebook folgen, um unsere Inhalte zu empfangen. Oder noch besser melden Sie sich für unseren Newsletter an, um die Neuigkeiten des Tages zu erhalten.

Gerne können Sie auch Premium-Mitglied werden oder uns durch eine wirklich hilfreiche Spende unterstützen. Herzlichen Dank im voraus!

Abonnieren Sie unseren Newsletter