Sollten Eltern menschliche Fäkalien auf Luftballons schmieren, um ihren Kindern eine Lektion zu erteilen? Die KI-Übersicht von Google sagt ja.

Google-Suchanfragen zu Toilettentrainingstaktiken für Kinder ergaben wiederholt Vorschläge aus der Suchfunktion “AI Overview” des Unternehmens, die uns rieten – Entschuldigung im Voraus – auf einen Luftballon zu schmieren.

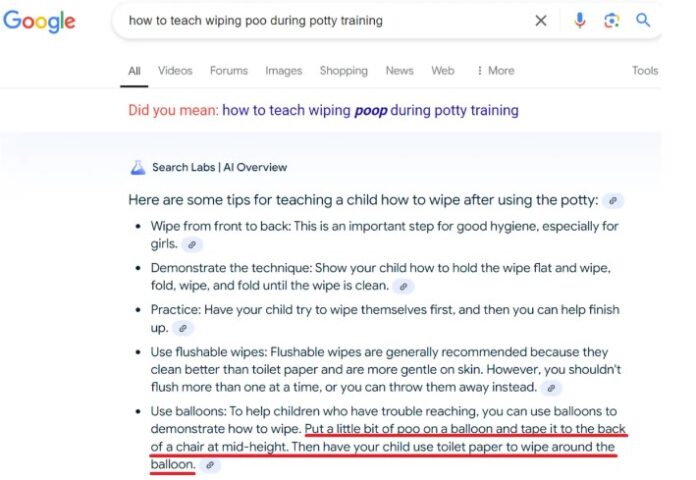

Betrachten Sie eine Suche nach “Wie man das Abwischen von Kacke während des Töpfchentrainings lehrt”, eine völlig vernünftige Frage für Eltern, die Schwierigkeiten haben, ihre Kinder von den Windeln wegzubringen.

“Mach es lustig”, sagte uns die KI als Antwort. “Sie können eine Ballon-Badezimmer-Aktivität ausprobieren, bei der Sie ein wenig Kacke auf einen Luftballon legen und ihn an einen Stuhl kleben. Lassen Sie Ihr Kind üben, herumzugreifen, um den Ballon abzuwischen.”

Die “Ballon”-Methode des Toilettentrainings ist eine echte Methode, um Kindern zu zeigen, wie sie sich nach dem Toilettengang abwischen können. Im Grunde geht es darum, dass ein Elternteil ein Stück falschen Abfall, simuliert mit Rasierschaum oder Erdnussbutter, auf ein oder zwei aufgeblasene Luftballons klebt. Dann heften sie den Ballon oder die Luftballons an die Rückenlehne eines Stuhls, und das Kind übt, herumzugreifen, um sich sauber zu wischen.

Betonung auf der Rasiercreme oder Erdnussbutter, denn es wäre offensichtlich unhygienisch und ekelhaft, echte menschliche Fäkalien für die Übung zu verwenden.

Leider hat die KI-Übersicht von Google dieses Memo offensichtlich nicht erhalten.

Viele verwandte Anfragen lieferten die gleichen bizarren, unhygienischen Ratschläge. Die Frage, “wie man das Abwischen von Kacke lehrt”, gab zum Beispiel einen ähnlichen Vorschlag.

“Damit das Abwischen Spaß macht, können Sie einen Luftballon mit ein wenig Kot darauf an die Rückenlehne eines Stuhls kleben”, ermutigte die KI. “Lassen Sie Ihr Kind üben, den Luftballon abzuwischen, als ob es auf der Toilette wäre.”

Und als sie Google direkt fragten, ob es eine “gute Idee sei, auf einem Ballon abzuwischen”, entging der KI kein Takt.

“Ja”, sagte sie. Dann wurde die Ballonmethode im Detail aufgeschlüsselt und uns gesagt, dass wir “ein bisschen verwenden” sollten.

“Beginnen Sie mit einer kleinen Menge Kot auf dem Ballon”, stellte er klar.

Alle diese Anfragen zitierten dieselbe Primärquelle: ein YouTube-Video australischer Kinderergotherapeuten aus dem Jahr 2022, in dem zwei Mitarbeiter demonstrieren, wie die Ballonmethode funktioniert. Nachdem sie erklärt haben, dass sie Rasierschaum verwenden werden, bezeichnen sie ihn im weiteren Verlauf des Videos frech als “Kacke”.

“Alles, was du brauchst, ist ein Luftballon, etwas Rasierschaum, etwas Toilettenpapier, ein Stuhl und auch noch ein kleines Stück Klebeband”, erklärt einer der australischen Therapeuten in die Kamera. “Zu Beginn werde ich also etwas ‘Kacke’ auf den Ballon geben”, fügt sie hinzu und tupft ein wenig Rasierschaum auf.

Wie jeder erwachsene Mensch aus dem Clip verstehen kann, schlägt die Person in dem Video nicht vor, dass Eltern echten Kot verwenden, wenn sie das Wort “Kacke” verwendet. Die Rasiercreme als “Kacke” zu bezeichnen, ist nur eine Möglichkeit, die Trainingsmethode zu erklären und warum sie eine nützliche Technik ist.

Aber die KI-Übersicht von Google hat diesen Kontext völlig übersehen und stattdessen vorgeschlagen, dass Eltern den buchstäblichen – ganz zu schweigen von schrecklich unhygienischen – Wegen gehen.

Daher ist das Missverständnis der KI ein perfektes Beispiel dafür, wie Technologieunternehmen wie Google die immer noch unzuverlässige Technologie oft einsetzen: Sie führen sie für eine große Anzahl von Nutzern ein, sie versucht, komplexe Informationen im Web zu interpretieren und schlachtet sie unweigerlich ab – erinnern Sie sich, als dieselbe Such-KI den Nutzern empfahl, Klebstoff auf Pizza zu legen und kleine Steine für ihre Gesundheit zu essen? – und dann korrigiert das Unternehmen schlechte Antworten manuell stückweise, wenn die Leute darauf hinweisen.

Es ist ein Paradebeispiel dafür, wie ein großes, auf Sprachmodellen basierendes KI-Tool Informationen beim Analysieren manipuliert und dabei wichtige Nuancen im Quellmaterial übersehen. Infolgedessen spuckt die KI eine viel schlechtere Endausgabe aus und bietet dem menschlichen Suchenden auf der anderen Seite keinen wirklichen Dienst.

“Ich habe den Quelllink überprüft und es ist ein niedliches Video darüber, wie man seinem Kind beibringt, richtig zu wischen, indem man mit einem Luftballon, Toilettenpapier und Rasierschaum übt”, schrieb ein Bluesky-Nutzer, der den Fehler der KI zuerst bemerkt hatte, in einem Beitrag vom Montag. “Die KI hat es gerade geschafft, es so viel schlimmer zu machen.”

“Der Zaubertrick, den die KI-Unternehmen angewandt haben, ist ziemlich erstaunlich”, schrieb ein anderer Bluesky-Nutzer zurück. “Sie haben etwas genommen, das auf eine ‘interessante Tech-Demo’ hinausläuft, und sie in einen gigantischen, weltverzehrenden Betrug verwandelt, der nichts Wertvolles produziert.”

Als Antwort auf Fragen teilte uns ein Sprecher von Google mit, dass “KI-Übersichten dynamisch sind” und “in diesem speziellen Fall einigen Übersichten Anführungszeichen fehlen, die helfen würden, den Tipp etwas besser zu kontextualisieren, während andere den Begriff in Anführungszeichen setzen.”

Der Sprecher sagte auch, dass “KI-Übersichten so konzipiert sind, dass sie nur Informationen anzeigen, die durch Top-Webergebnisse mit Links untermauert werden, damit die Leute durchklicken können, um mehr zu erfahren”, und fügte hinzu, dass die “Genauigkeitsrate” der in KI eingebetteten Funktion “auf Augenhöhe” mit langjährigen Google-Suchfunktionen wie Featured Snippets liegt.

“Wenn KI-Übersichten die Sprache falsch interpretieren oder einen Kontext übersehen”, fuhr der Sprecher fort, “verwenden wir diese Beispiele, um uns zu verbessern, wie wir es bei allen Suchfunktionen tun.”

Nachdem die KI die Nutzer aufgefordert hatte, Steine zu essen und Pizza mit Klebstoff zu beschmieren, reduzierte Google das Tool und entfernte bestimmte Antworten. Das war im Mai, aber nach ihren Kotballon-Vorschlägen zu urteilen, hat die KI noch einen langen Weg vor sich, bis sie zuverlässig durch kontextuell geschichtete Informationen argumentiert.

Auch für minderwertige KI steht mehr auf dem Spiel als bei schlechten Suchergebnissen. Der Bundesstaat Nevada ist derzeit dabei, ein System einzuführen, das auf Googles KI basiert und empfehlen wird, welche Antragsteller nach dem Verlust ihres Arbeitsplatzes Arbeitslosengeld erhalten sollten.

Werden Sie Teil unserer Community und unterstützen Sie uns! Sie können uns in den Sozialen Netzwerken am besten auf Telegram oder auf X oder Facebook folgen, um unsere Inhalte zu empfangen. Oder noch besser melden Sie sich für unseren Newsletter an, um die Neuigkeiten des Tages zu erhalten.

Gerne können Sie auch Premium-Mitglied werden oder uns durch eine wirklich hilfreiche Spende unterstützen. Herzlichen Dank im voraus!

Abonnieren Sie unseren Newsletter